Warum Sie jetzt handeln müssen

Strikte Fristen

- Der Gesetzgeber hat für bestimmte KI-Systeme und KI-Modelle unterschiedliche Vorgaben und Umsetzungszeitpunkte definiert.

- Bis dahin müssen die entsprechenden Verordnungen umgesetzt sein.

- Neben dem Verbot bestimmter KI-Systeme ab Februar 2025, treten im August 2025 bestimmte Anforderungen für GPAI-Modelle in Kraft. Diese werden in dem Wiki dieser Seite ausführlich erläutert.

- In den Jahren darauf treten die Bestimmungen für Hochrisiko-KI-Systeme in Kraft (z.B. Medizinische Diagnostik, Kreditwürdigkeitsbewertung im Finanzwesen, KI-Systeme für Entscheidungen im Personalmanagement).

Erhebliche Sanktionen

- Wurden die Anforderungen nicht umgesetzt, drohen scharfe Sanktionen.

- Bei Missachtung des Verbots bestimmter KI-Praktiken (Artikel 5 KI-VO) drohen Geldbußen von bis zu 35.000.000 € oder – im Falle von Unternehmen – von bis zu 7% des gesamten weltweiten Jahresumsatzes des vorangegangenen Geschäftsjahres, je nachdem, welcher Betrag höher ist.

- Für Verstöße gegen die in Art. 99 (4) KI-VO festgelegten Bestimmungen drohen Geldbußen von bis zu 15.000.000 € oder – im Falle von Unternehmen – von bis zu 3% des gesamten weltweiten Jahresumsatzes des vorangegangenen Geschäftsjahres, je nachdem welcher Betrag höher ist.

Kernaspekte der EU AI Act Umsetzung

Betroffene Unternehmen

- Der EU AI Act definiert – anders als die anderen Produktsicherheitsverordnungen – einen horizontalen Ansatz und gilt somit branchenübergreifend und kann damit jedes Unternehmen betreffen.

- Anbieter innerhalb oder außerhalb der EU, die in der EU KI-Systeme in Verkehr bringen oder in Betrieb nehmen oder GPAI-Modelle in Verkehr bringen

- Betreiber von KI-Systemen mit Sitz oder Aufenthalt in der EU

- Anbieter und Betreiber in einem Drittland, wenn die Ausgabe des KI-Systems in der EU verwendet wird

- Einführer und Händler von KI-Systemen

- Produkthersteller, wenn sie KI-Systeme mit ihrem Produkt in Verkehr bringen oder in Betrieb nehmen

- Bevollmächtigte von Anbietern aus einem Drittland

- Betroffene Personen mit Aufenthalt in der EU

Pflichten und Anforderungen

- Verbot von KI-Systemen mit unannehmbaren Risiken

- Für Hochrisiko-KI-Systeme gelten die Anforderungen aus Kapitel III Abschnitt 2 KI-VO:

- Transparenzanforderungen gem. Art. 50 KI-VO für bestimmte KI-Systeme, die in der Regel mit Menschen interagieren

- Anforderungen für Anbieter von GPAI-Modellen gem. Kapitel V KI-VO

Unsere EU AI Act Dienstleistungen für Sie

KI-Kompetenz Training:

-

Artikel 4 KI-VO schreibt vor, dass Anbieter und Betreiber von KI-Systemen dafür sorgen müssen, dass ihr Personal und beauftragtes Personal, insoweit sie sich mit KI-Systemen befassen, die notwendigen Kompetenzen aufweisen müssen.

-

Im Rahmen des Trainings übermitteln wir Wissen aus dem Bereich der KI-Literacy und schulen Sie mit den notwendigen Informationen.

Risikokategorisierung:

-

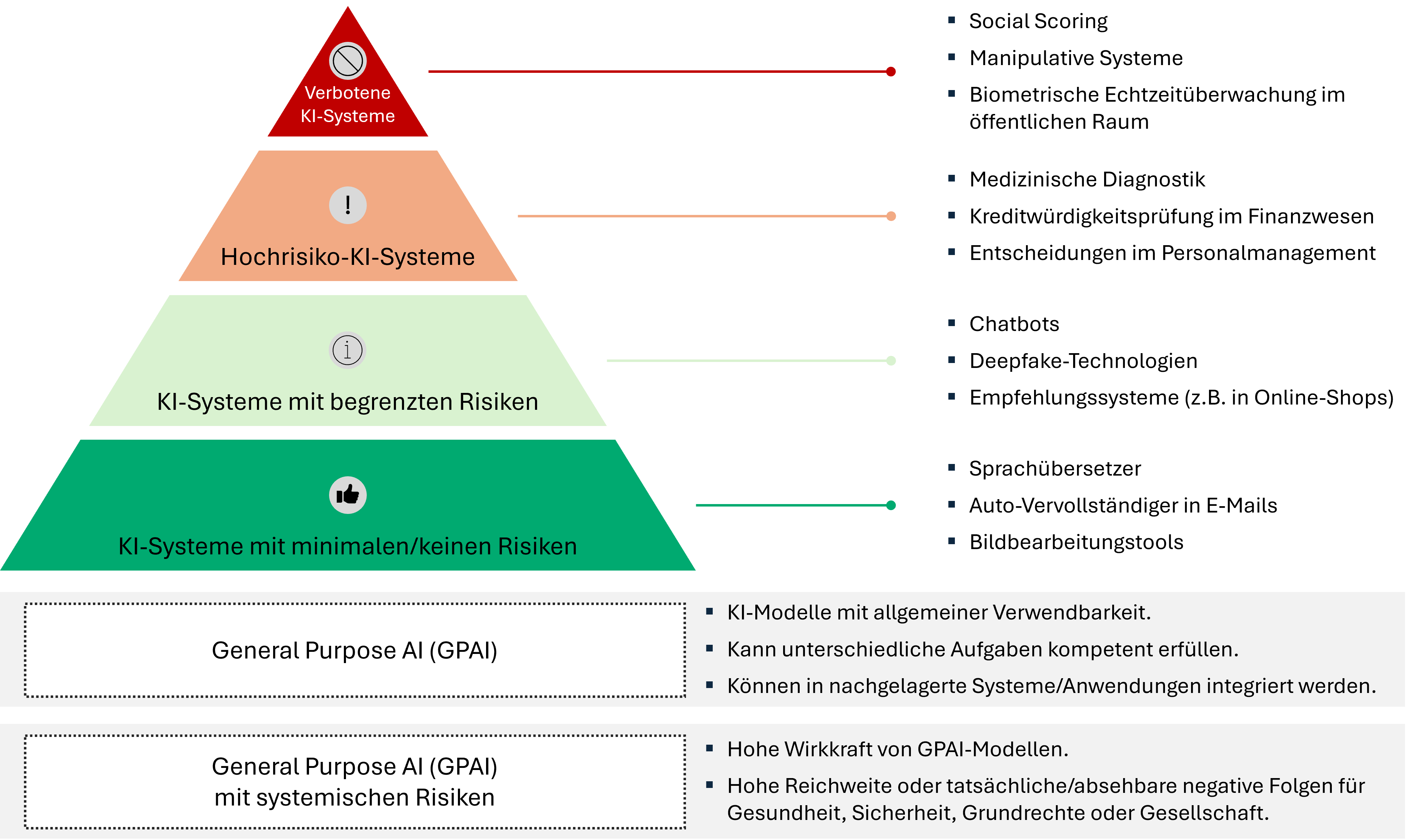

Die KI-VO ordnet KI-Systeme in vier Risikokategorien ein und definiert für KI-Systeme aus den jeweiligen Klassen unterschiedliche Anforderungen.

-

Wir unterstützen Sie bei der adäquaten Risikokategorisierung und sorgen damit für Ihre Compliance.

-

Als Werkzeug unterstützt uns hierbei das in unserem Haus entwickelte automatisierte Risikokategorisierungs-Tool für Ticketsysteme.

Identifikation von KI-Systemen und GPAI-Modellen

-

Die Systemlandschaft von Unternehmen ist sehr vielfältig und oftmals ist nicht direkt ersichtlich, ob und welche KI-Systeme und KI-Modelle in einem Unternehmen eingesetzt werden. Die zunehmende Anwendung von Tools wie ChatGPT und MS Copilot verdeutlicht die Relevanz.

-

Wir unterstützen Sie bei der Identifikation von KI-Systemen und GPAI-Modellen und richten entsprechende Register für Sie ein.

Gap-Analyse

-

Sind KI-Systeme und GPAI-Modelle identifiziert, muss geprüft werden, inwiefern sie die jeweiligen Anforderungen des EU AI Acts erfüllen.

-

Wir unterstützen Sie dabei im Rahmen einer Gap-Analyse und helfen bei der Schließung der identifizierten Lücken.

Konformitätsbewertung

-

KI-Systeme, die in den Hochrisiko-Bereich fallen, unterliegen vor dem Inverkehrbringen oder der Inbetriebnahme gem. Artikel 43 KI-VO einer Pflicht zur Konformitätsbewertung.

-

Wir unterstützen Sie bei der Durchführung einer solchen Konformitätsbewertung für jedes Ihrer betroffenen KI-Systeme.

-

Wir bieten das KI-generierte Tracking bei den laufenden Anpassungen Ihrer Systeme an, um Ihre Konformitätsanalyse so kapazitäts- und kostenneutral wie möglich zu gestalten.

Risikomanagementsystem

-

Für KI-Systeme, die in den Hochrisiko-Bereich fallen, muss nach Artikel 9 (1) KI-VO ein Risikomanagementsystem eingerichtet, umgesetzt, dokumentiert und aufrechterhalten werden.

-

Wir unterstützen Sie hierbei und tragen dazu bei, dass Ihre Risiken adäquat identifiziert, bewertet und behandelt werden.

-

In diesem Rahmen eignet sich die Implementierung eines KI-Management-Systems und die Integration des Risikomanagementsystems in dieses.

Häufig gestellte Fragen (FAQ) zum EU AI Act

Hier finden Sie Antworten auf häufig gestellte Fragen zum EU AI Act und zu unseren Dienstleistungen.

Warum ADVISORI FTC?

20 Jahre regulatorische Expertise

Langjährige Erfahrung in der Umsetzung komplexer Regulierungen wie EU AI Act

130+ Regulatorik-Experten, Berater, IT-Experten

Tiefes Branchenwissen für Ihre EU AI Act-Compliance

ISO 27001 zertifiziert

Garantierte Sicherheitsstandards in Übereinstimmung mit DIN EN ISO/IEC 27001:2024

AI Managementsystem

vollständiges Team ISO42001-zertifiziert

Expertise EU AI Act

Anforderungen, Bestimmung der Risikokategorie einzelner Anwendungen, Auditvorbereitung

Erfahrung NIST AI Risk Management Framework

Implementierung

Unser Expertenteam für Ihre EU AI Act Compliance

Mit umfassender Expertise in KI-Regulierung und Compliance unterstützen wir Ihr Unternehmen dabei, die Anforderungen des EU AI Acts zu erfüllen und KI-Systeme sicher und verantwortungsvoll einzusetzen.

Asan Stefanski

Team Head Digital Transformation | ADVISORI FTC GmbH

- 10+ Jahre Erfahrung in der Informationssicherheit und Softwareentwicklung

- Jahrelange Erfahrung in der Umsetzung von Softwareentwicklungsprojekten bei Großkonzernen

- Projekte in Gesundheitswesen, Zahlungsdienstleister und Automobil

- Experte für IT-Sicherheit und Software-Engineering

Jana Schöneborn

Principal Consultant Digital Transformation | ADVISORI FTC GmbH

- 8+ Jahre Beratungserfahrung

- Relevante Zertifizierungen, u.a. ISO42001 Foundation, COBIT, Leading Strategic Projects u.a.

- Jahrelange Erfahrung im Projekt- und Stakeholdermanagement, Business Analyse & Requirements Engineering

- Projekte im Bereich Daten: DWH, Datalake, Datenanalyse, Dashboard etc.

- Expertin AI Regulatorik

Inna Vogel

Senior Consultant Digital Transformation | ADVISORI FTC GmbH

- 7+ Jahre Expertise in den Bereichen KI und maschinelles Lernen

- Jahrelange Erfahrung in der Umsetzung und Leitung von KI-Projekten in Forschung und Industrie

- Projekte in verschiedenen Sicherheitsbehörden und Forschungsprojekten

- Expertin für die Umsetzung von KI-Projekten und KI-Regulierung

Unser Team in Zahlen

120+

Cybersecurity-Experten

490+

Erfolgreich abgeschlossene Projekte

15+

KRITIS Branchen Erfahrung

15+

Jahre regulatorische Erfahrung

Unsere Expertise umfasst:

- Regulatorische Anforderungen für AI

- Konformitätsbewertung

- AI GRC

- Strategieentwicklung für KI

- Datenmanagement

- Organisationsentwicklung/Change Management

- Beratung zu regulatorischen Anforderungen und Standards (ISO 42001)

- Risikomanagementsystem

- AI Kompetenz

- Risikokategorisierung

- GAP-Analyse

- Identifikation von AI Systemen

Profitieren Sie von unserem Expertenwissen für den EU AI Act

Fragen Sie unser ExpertenteamWarum führende DAX 30 Unternehmen uns vertrauen

Unsere Expertise, Auszeichnungen und Partnerschaften machen uns zum vertrauenswürdigen Partner für Ihre EU AI Act Compliance:

Ausgezeichnete Kundenbewertungen

4.8 von 5 Sternen

Basierend auf über 100 Kundenbewertungen

ADVISORI Auszeichnungen

EU AI Act Roadmap

1. Erstellung eines Inventars für KI-Systeme und KI-Modelle:

- Entwickelte, in Betrieb genommene, importierte und vertriebene KI-Systeme und GPAI-Modelle auflisten und bewerten.

- Bewertung dokumentieren.

- Inventar regelmäßig überprüfen und aktuell halten.

2. KI-Systeme und GPAI-Modelle klassifizieren:

- Prüfen, ob ein Ausnahmefall vorliegt (z.B. ein vermeintlich hochriskantes KI-System, das kein hohes Risiko für die Gesundheit, Sicherheit und Grundrechte von Individuen aufweist)

- Bewertung dokumentieren.

- Entwicklungen und Neuerungen durch die Europäische Kommission beobachten.

- Beurteilung regelmäßig überprüfen und aktuell halten.

3. Rolle der Organisation für jedes KI-System/GPAI Modell festlegen und beurteilen, ob die Organisation dem EU AI Act unterliegt:

- Berücksichtigen, dass auch Organisationen aus Drittländern dem EU AI Act unterliegen können.

- Berücksichtigen, dass die Rolle der Organisation (z.B. Anbieter/Betreiber) abhängig ist vom betroffenen KI-System/GPAI-Modell.

- Dokumentation der Beurteilung der Organisationsrolle für jedes KI-System/GPAI-Modell.

- Beurteilung überwachen und regelmäßig prüfen, ob eine Aktualisierung erforderlich ist.

4. Verpflichtungen den KI-Systemen/GPAI-Modellen zuordnen:

- Identifikation der Pflichten für jedes KI-System/GPAI-Modell auf Basis der Risikokategorisierung und Unternehmensrolle.

- Während manche Dokumentationen (z.B. technische Dokumentation) für spezifische KI-Systeme/GPAI-Modelle angefertigt werden müssen, können manche Richtlinien, Prozesse oder Maßnahmen für alle KI-Systeme/GPAI-Modelle Anwendung finden (z.B. AI-Literacy Maßnahmen).

- Vorlagen und Richtlinien der Europäischen Kommission/des KI-Büros/des KI-Boards/der nationalen Aufsichtsbehörden (Regulatoren) im Blick behalten und ggf. anwenden.

- Die Anwendung harmonisierter Standards von Standardisierungsorganisationen oder gängiger Spezifikationen, die von der EU-Kommission ausgegeben wurden, können dabei unterstützen Compliance zu demonstrieren.

5. Regulatorische Überschneidungen identifizieren:

- Identifikation von regulatorischen Überschneidungen und Widersprüchen insbesondere bei Tätigkeit in stark regulierten Sektoren (z.B. Biologie, Finanzsektor)

- Beurteilung und Dokumentation, ob durch die bereits erfolgende Einhaltung von sektorspezifischen Anforderungen auch Anforderungen des EU AI Acts erfüllt werden.

- Werden widersprüchliche Anforderungen festgestellt oder kommen sonstige Schwierigkeiten auf, sollten die zuständigen Behörden konsultiert werden.

6. Inventar für vorhandene Dokumentationen und Prozesse erstellen, sowie Gap-Analyse durchführen:

- Erstellung eines Inventars für vorliegende Dokumentationen und Prozesse.

- Gap-Analyse durchführen zwischen dem Status Quo und dem erforderlichen Zielzustand.

- Schließung der identifizierten Lücken mittels geeigneter Maßnahmen.

7. Interne Ressourcen und Bedarf ermitteln:

- Abteilungsübergreifendes Team festlegen.

- Verfügbare Ressourcen bewerten (Personal, Finanzen, Technik) in Bezug auf die KI-Systeme/GPAI Modelle.

- Organisationsweiten Trainingsbedarf ermitteln.

- Bereiche identifizieren, für die externe Unterstützung/Outsourcing benötigt wird.

- Budgetierungen durchführen.

8. Roadmap definieren und Verantwortlichkeiten zuordnen:

- Entwicklung eines Plans trägt dazu bei, dass Aufgaben adäquat verteilt und Deadlines eingehalten werden.

- Konkrete Handlungsmaßnahmen definieren und nach Priorität organisieren.

- Verantwortlichkeiten zuordnen und Deadlines festlegen.

- Plan aktuell halten und Fortschritt beobachten.

9. Regulatorische Entwicklungen beobachten:

- Von Regulatoren zur Verfügung gestellte Ressourcen beobachten, wie Richtlinien, Implementierungsregulierungen, Vorlagen etc.

- Teilnahme an Konsultationsprozessen und Workshops, die von Regulatoren organisiert werden.

- Entwicklungen laufend beobachten.

- Durchsetzungsmaßnahmen beobachten, um die Prioritäten der Regulatoren zu verstehen.

- Mit Regulatoren kooperieren.

10. Nutzung von regulatorischen „Sandboxes", Verhaltenskodizes und Standardisierungen

- Nutzung von regulatorischen „Sandboxes"

- Beobachtung und Teilnahme an der Entwicklung von Verhaltenskodizes

- Beobachtung und Teilnahme an der Entwicklung von Standards, die von Standardisierungsorganisationen entwickelt werden

Unser Interview mit Prof. Dr. Janine Wendt

EU AI Act WIKI

Disclaimer

Die folgenden Inhalte basieren auf Informationen von Veröffentlichungen, die einer laufenden Anpassung unterliegen. Somit kann keine Fehlerfreiheit und Vollständigkeit garantiert werden. In einem Gespräch mit unseren Experten haben Sie die Möglichkeit alle offenen Fragen und Anmerkungen jederzeit anzusprechen.

Inhaltsverzeichnis

- 1. Geltungsbereich und betroffene Unternehmen

- 2. Kernkomponenten des EU AI Acts

- 3. Bedeutung des EU AI Acts für die Unternehmenslandschaft mit Fokus auf KMU

- 4. EU AI Act: Zeitplan und wichtige Fristen

- 5. Vorbereitung auf die Implementierung (AI-Pact)

- 6. Sanktionen und Bußgelder bei Nichteinhaltung

- 7. Bedeutung der Trustworthy AI

- 8. Risikokategorien und entsprechende Anforderungen

- 9. Implementierung eines Qualitätsmanagementsystems

- 10. Implementierung eines AI Management Systems nach ISO/IEC 42001

- 11. Risikomanagementsysteme und das NIST RMF

- 12. Durchführung einer Konformitätsbewertung

- 13. CE-Siegel nach erfolgter Konformität

- 14. Konformitätsvermutung durch die Einhaltung von harmonisierten Normen

- 15. Wesentliche Änderungen und damit verbundene Pflichten

- 16. General Purpose AI-Modelle (GPAI)

- 17. Aufbau von KI-Kompetenzen

- 18. Identifikation von KI-Systemen und Wichtigkeit der Bildung eines Registers

- 19. Durchsetzende Behörden

- 20. Quellen

Geltungsbereich und betroffene Unternehmen

Wen betrifft der EU AI Act?

- Der Geltungsbereich der Verordnung ist geregelt in Art. 2 (1) EU AI Act.

- Anbieter innerhalb oder außerhalb der EU, die in der EU KI-Systeme in Verkehr bringen oder in Betrieb nehmen oder GPAI-Modelle in Verkehr bringen.

- Betreiber von KI-Systemen mit Sitz oder Aufenthalt in der EU.

- Anbieter und Betreiber in einem Drittland, wenn die Ausgabe des KI-Systems in der EU verwendet wird.

- Einführer und Händler von KI-Systemen.

- Produkthersteller, wenn sie KI-Systeme mit ihrem Produkt in Verkehr bringen oder in Betrieb nehmen.

- Bevollmächtigte von Anbietern aus einem Drittland.

- Betroffene Personen mit Aufenthalt in der EU.

Wofür gilt der EU AI Act nicht?

- KI-Systeme für die Zwecke aus dem Bereich des Militärs, der Verteidigung oder der nationalen Sicherheit.

- KI-Systeme, die ausschließlich in einem Drittland in Verkehr gebracht oder betrieben werden und deren Ausgaben in der EU ausschließlich für Zwecke aus dem Militär, der Verteidigung oder der nationalen Sicherheit verwendet werden.

- Behörden in Drittländern oder internationale Organisationen, falls die KI-Systeme im Rahmen der Strafverfolgung oder justiziellen Zusammenarbeit eingesetzt werden, wobei Garantien für den Schutz von Privatsphäre, Grundrechte und Grundfreiheiten von Personen geboten werden.

- KI-Systeme oder -Modelle (inkl. Output) in der wissenschaftlichen Forschung und Entwicklung.

- Forschungs-, Test- und Entwicklungstätigkeiten zu KI-Systemen oder -Modellen vor Inbetriebnahme oder Inverkehrbringen (Ausnahme: Tests unter Realbedingungen).

- Natürliche Personen, die KI-Systeme ausschließlich persönlich und nicht beruflich verwenden.

- Lizenzfreie und quelloffene KI-Systeme (Ausnahme: Verbotene, hochriskante oder transparenzpflichtige KI-Systeme).

Kernkomponenten des EU AI Acts

Was ist der EU AI Act?

- Der EU AI Act ist eine EU-Verordnung (Verordnung (EU) 2024/1689), welche neben der Änderung von anderen Verordnungen vor allem harmonisierte Vorschriften für Künstliche Intelligenz festlegt.

- Gilt als Produktsicherheitsrecht und hebt sich von den anderen Verordnungen zu Produktsicherheit mit ihrem horizontalen Ansatz ab.

- Der horizontale Rechtsrahmen reguliert nicht einzelne Branchen, sondern definiert branchenübergreifende Anforderungen.

- Primär reguliert wird nicht die Technologie oder das KI-System selbst, sondern der Anwendungsbereich. Der Fokus liegt somit darauf, wie und wofür ein KI-System verwendet wird.

Was sind die Ziele des EU AI Acts?

- Zweck der Verordnung ist die Verbesserung des Funktionierens des Binnenmarktes, indem ein einheitlicher Rechtsrahmen für Entwicklung, Inverkehrbringen, Inbetriebnahme und Verwendung von KI-Systemen in der Union im Einklang mit den EU-Werten aus der Charta festgelegt wird.

- Im Vordergrund steht die Förderung von menschenzentrierter und vertrauenswürdiger KI und die Sicherstellung von Gesundheitsschutz, Sicherheit und Grundrechten.

- Schädliche Auswirkungen von KI-Systemen in der EU sollen vermieden und Innovationen sollen unterstützt werden.

Warum ist der EU AI Act wichtig für Unternehmen?

Compliance

Unternehmen müssen gesetzliche Anforderungen erfüllen, um in Zukunft rechtssicher zu agieren. Nichtkonformität führt zu hohen Strafen.

Reputation

Verstöße gegen das neue Gesetz können zu Reputationsschäden führen, wenn KI-Systeme eines Unternehmens ethisch oder rechtlich bedenklich sind. Der Fokus auf Transparenz ist hierbei von besonderer Bedeutung, um Kundenvertrauen zu schaffen.

Marktzugang

Neben der Differenzierungsmöglichkeit durch „vertrauenswürdiger KI“ müssen Unternehmen die Vorschriften einhalten, um Zugang zum europäischen Markt zu erhalten.

Risiko und Haftung

Mit der Anwendung des Gesetzes können Risiken in Bezug auf KI besser identifiziert, eingeschätzt und behandelt werden.

Bedeutung des EU AI Acts für die Unternehmenslandschaft mit Fokus auf KMU

Was bedeutet der EU AI Act allgemein?

- Unternehmen, die aktuell künstliche Intelligenz verwenden oder in Zukunft in ihre Systeme implementieren möchten, sehen sich in naher Zukunft mit regulatorischen Anforderungen konfrontiert und müssen Handlungsbedarfe rechtzeitig identifizieren und implementieren, um Strafen oder Rufschäden zu vermeiden.

- Der Verzicht des Einsatzes von KI könnte auf der anderen Seite dazu führen, dass Potenziale bezüglich Kosteneinsparungen und Effizienzsteigerungen nicht genutzt werden.

Was bedeutet der EU AI Act für KMU?

- Kleinere und mittelgroße Unternehmen stehen in diesem Zusammenhang vor besonderen Herausforderungen.

- Hoher finanzieller und personeller Aufwand für die Umsetzung von Anforderungen (insbesondere für hochriskante-KI-Systeme), z.B. in Bezug auf die Etablierung eines internen Risikomanagementsystems, technologische Anpassungen, oder juristische Anforderungen.

- Begrenzte Ressourcen für die Umsetzung regulatorischer Vorgaben.

- Hohe Komplexität in Bezug auf Verständnis und Umsetzung der umfangreichen Vorschriften.

- Aus diesem Grund sieht die EU spezielle Unterstützungen für KMU und Start-ups vor, wie regulatorische Sandboxes und Förderprogramme. Zudem können KMUs sich durch die frühzeitige Anpassung als Vorreiter in Nischenmärkten positionieren.

EU AI Act: Zeitplan und wichtige Fristen

Zeitplan und wichtige Fristen

- Das Gesetz erschien am 12. Juli 2024 im EU-Amtsblatt und ist demnach am 01. August 2024 in Kraft getreten.

- Seit dem letzteren Datum treten einzelne Bestimmungen nach und nach in Kraft, wobei das Gesetz nach zwei Jahren gänzlich Anwendung findet, mit Ausnahme der Hochrisiko-KI-Systeme gemäß Annex II.

01. August 2024

Inkrafttreten

02. Februar 2025

- Verbot von Systemen mit unannehmbaren Risiken

- Sicherstellung von KI-Kompetenzen (AI-Literacy)

02. August 2025

- Vorschriften für GPAI-Modelle gelten

- Staat benennt mindestens eine notifizierende Behörde

- Governance: auf Unionsebene und Nationalebene werden vorgesehene Behörden und

Institutionen eingerichtet und benannt

- Strafbestimmungen gelten

02. August 2026

- Rechtliche Bestimmungen für Hochrisiko-KI-Systeme (Annex III) treten in Kraft

- Transparenzvorschriften für KI-Systeme mit geringem und minimalem Risiko gelten

- KI-Reallabore müssen einsatzbereit sein

- sonstige Verpflichtungen

02. August 2027

Rechtliche Bestimmungen für Hochrisiko-KI-Systeme (Annex I) treten in Kraft

Was gilt für KI-Systeme, die bereits auf dem Markt sind oder in Betrieb genommen wurden?

- Hochrisiko-KI-Systeme müssen ab dem Zeitpunkt einer wesentlichen Änderung in Übereinstimmung mit dem EU AI Act gebracht werden.

- Hochrisiko-KI-Systeme, welche für Behörden bestimmt sind, innerhalb von 6 Jahren nach Inkrafttreten (02.08.2030).

- GPAI-Systeme innerhalb von 3 Jahren ab Inkrafttreten des EU AI Acts (02.08.2027).

- KI-Systeme, die Teil der IT-Großsysteme im Bereich Freiheit, Sicherheit und Recht sind, bis zum Jahr 2030.

Vorbereitung auf die Implementierung (AI-Pact)

Was ist der AI-Pact?

- Während einige Bestimmungen des EU AI Acts mit dem Inkrafttreten zum 01. August 2024 vollständig Anwendung finden, gelten andere Anforderungen am Ende eines Übergangszeitraums.

- Mit dem KI-Pakt möchte die Kommission die Interessenträger bei der Vorbereitung auf die Umsetzung des KI-Gesetzes unterstützen.

- Der AI-Pact ist eine freiwillige Vereinbarung, mit der Organisationen dazu ermutigt werden sollen, schon vor Inkrafttreten des Gesetzes Maßnahmen zu ergreifen, die den Anforderungen der Verordnung entsprechen.

Wie ist der Zwei-Säulen-Ansatz des AI-Pacts definiert?

- Säule I:

- Interaktion mit allen Stakeholdern durch Webinare.

- Offen für alle Arten von Organisationen.

- Organisation von Webinaren, die allen Interessenträgern offenstehen, um bestimmte Aspekte des KI-Gesetzes zu behandeln (öffentlich, privat, NGOs, etc.).

- Austausch mit Interessenträgern darüber, wie das Amt für KI Organisationen bei der Umsetzung des EU AI Acts unterstützen kann.

- Säule II:

- Freiwillige Zusagen für Unternehmen jeder Größe.

- Fokus liegt auf Provider und Deployer.

- Freiwillige Zusagen, in denen Organisationen aufgefordert werden, proaktiv auf Maßnahmen zur Umsetzung einiger der wichtigsten Bestimmungen des EU AI Acts hinzuarbeiten.

- Workshops, die Speziell auf die Unternehmen zugeschnitten sind.

Sanktionen und Bußgelder bei Nichteinhaltung

Was ist die Rolle der Mitgliedstaaten?

- Gemäß Artikel 99 EU AI Act erlassen die Mitgliedstaaten Vorschriften für Sanktionen und andere Durchsetzungsmaßnahmen.

- ergreifen Maßnahmen, die für deren ordnungsgemäße und wirksame Durchsetzung notwendig sind.

Welche Sanktionen drohen bei Nichteinhaltung und gibt es Ausnahmen?

- Bei Missachtung des Verbots der in Artikel 5 genannten Praktiken (Verbotene KI-Praktiken) drohen Geldbußen von bis zu 35.000.000 € oder – im Falle von Unternehmen – von bis zu 7% des gesamten weltweiten Jahresumsatzes des vorangegangenen Geschäftsjahres, je nachdem, welcher Betrag höher ist.

- Für Verstöße gegen die in Art. 99 (4) festgelegten Bestimmungen, die für Akteure oder notifizierte Stellen gelten, können Geldbußen von bis zu 15.000.000 € oder – im Falle von Unternehmen – von bis zu 3% des gesamten weltweiten Jahresumsatzes des vorangegangenen Geschäftsjahres, je nachdem welcher Betrag höher ist.

- Ausnahme: Für KMU und Start-Ups gilt nach Art. 99 (6) immer der jeweils geringere Betrag.

Bedeutung der Trustworthy AI

Was ist vertrauenswürdige KI?

- Im Rahmen des menschenzentrierten Ansatzes ist die Förderung von vertrauenswürdiger KI in der Europäischen Union eines der Hauptziele des EU AI Acts.

- Vertrauenswürdige KI umfasst die Entwicklung und den Einsatz von KI-Systemen, die ethischen, rechtlichen und technischen Standards entsprechen.

- Damit soll Sicherheit, Fairness, Transparenz und Zuverlässigkeit sichergestellt werden.

- Die frühzeitige Implementierung ermöglicht die Differenzierung vom Wettbewerb, indem regulatorische Anforderungen noch vor Inkrafttreten implementiert werden.

- Dies schafft auch ein höheres Kundenvertrauen, indem das Unternehmen Verantwortungsbewusstsein signalisiert.

Was sind die Grundpfeiler?

- Respektierung von Grundrechten.

- Compliance mit rechtlichen Vorgaben.

- technische Robustheit, Zuverlässigkeit, Ausfallsicherheit und IT- und Cybersicherheit.

- Transparenz zur Nachvollziehbarkeit der Funktionsweise und Ergebnisse,

- definierte Verantwortlichkeiten.

- Nutzerzentrierung.

Risikokategorien und entsprechende Anforderungen

Was sind Risikokategorien und welche Anforderungen sind definiert?

- Anders als andere Regelwerke, definiert der EU AI Act einen risikobasierten Ansatz, wobei vier Risikokategorien identifiziert werden können.

- Unannehmbares Risiko: Hierunter fallen KI-Systeme, die eine unannehmbare Gefahr für Sicherheit, Grundrechte oder Freiheiten von Menschen darstellen und daher verboten sind.

- Hochrisiko: KI-Systeme mit hohem Risiko haben erhebliche Auswirkungen auf Grundrechte oder Sicherheit und unterliegen zahlreichen Anforderungen, die in Abschnitt II des EU AI Acts definiert sind.

- Begrenztes Risiko: Systeme in dieser Kategorie interagieren in der Regel direkt mit natürlichen Personen und unterliegen Transparenzanforderungen, die in Artikel 50 des EU AI Acts geregelt sind.

- Minimales Risiko: Es wird geschätzt, dass die meisten KI-Systeme in diese Kategorie fallen. Sie stellen keine oder nur geringe Risiken für die Gesellschaft dar und sind nicht reguliert.

In welche Risikokategorie fällt mein KI-System?

- Dies kann nicht pauschal festgelegt werden und hängt grundsätzlich vom Anwendungsbereich des KI-Systems ab.

- Einige typische KI-Systeme können aber schon einzelnen Risikoklassen

zugeordnet werden, z.B.:

- Verbotene KI-Systeme: Soziale Bewertung durch Staaten, Manipulative Systeme, Biometrische Echtzeitüberwachung im öffentlichen Raum.

- Hochrisiko-KI-Systeme: Medizinische Diagnostik, Kreditwürdigkeitsbewertung im Finanzwesen, KI-Systeme für Entscheidungen im Personalmanagement.

- KI-Systeme mit begrenzten Risiken: Chatbots, Deepfake-Technologien, Empfehlungssysteme (z.B. in Online-Shops).

- KI-Systeme mit minimalen/keinen Risiken: Sprachübersetzer, Auto-Vervollständiger in E-Mails, Bildbearbeitungstools.

Implementierung eines Qualitätsmanagementsystems

Wer muss ein Qualitätsmanagementsystem einrichten?

- Artikel 16 KI-VO schreibt vor, dass Anbieter von Hochrisiko-KI-Systemen über ein Qualitätsmanagementsystem verfügen sollen.

- Dieses Qualitätsmanagementsystem muss den Anforderungen aus Artikel 17 KI-VO entsprechen.

- Als Annäherung kann hierbei der ISO/IEC 42001 Standard für AI Management Systeme verwendet werden.

Was muss ein Qualitätsmanagementsystem nach Art. 17 (1) KI-VO beinhalten?

- Konzept zur Einhaltung der Regulierungsvorschriften.

- Techniken, Verfahren und systematische Maßnahmen für Entwurf, Entwurfskontrolle, Entwurfsprüfung, Entwicklung, Qualitätskontrolle und Qualitätssicherung des Hochrisiko-KI-Systems.

- Untersuchungs-, Test- und Validierungsverfahren.

- Anzuwendende technische Spezifikationen und Normen.

- Systeme und Verfahren für das Datenmanagement.

- Risikomanagementsystem nach Art. 9.

- System zur Beobachtung nach Inverkehrbringen.

- Meldungsverfahren schwerwiegender Vorfälle gem. Artikel 73.

- Kommunikationsmanagement.

- Systeme und Verfahren für Aufzeichnungen.

- Ressourcenmanagement.

- Rechenschaftsrahmen.

Implementierung eines AI Management Systems nach ISO/IEC 42001

Was ist ein AI Management System (AIMS)?

- Nach ISO/IEC 42001 ist es eine Reihe von miteinander verbundenen und interagierenden Elementen einer Organisation.

- Diese dienen dazu Richtlinien, Ziele und Prozesse zur Zielerreichung in Bezug auf eine verantwortungsvolle Entwicklung, Bereitstellung und Nutzung von KI-Systemen festzulegen.

- Im Rahmen eines AIMS wird der gesamte Lebenszyklus von KI-Projekten in einer Organisation geplant, entwickelt, implementiert, überwacht und verwaltet.

- In diesem Rahmen soll sichergestellt werden, dass KI-Systeme effizient, sicher, ethisch korrekt und den gesetzlichen Anforderungen entsprechend entwickelt und betrieben werden.

Wie wirkt sich die Implementierung eines AIMS nach ISO auf die Compliance mit dem EU AI Act aus?

- Der Joint Research Center (JRC) der EU-Kommission glich die Anforderungen des EU AI Acts mit dem Inhalt der ISO/IEC 42001 ab in Bezug auf hochrisiko-KI-Systemen.

- Das in ISO/IEC 42001 beschriebene AI-Managementsystem entspricht weitgehend den Anforderungen des AI-Gesetzes an ein Qualitätsmanagementsystem.

- Obwohl der flexible Ansatz der ISO mit den optionalen Controls nicht vollständig mit dem EU AI Act vereinbar ist, bietet diese ISO eine solide Basis für die Implementierung eines Systems zum Management von KI.

Risikomanagementsysteme und das NIST RMF

Was regelt der EU AI Act für Risikomanagementsysteme?

- Art. 17 (1) g) KI-VO sieht vor, dass das für hochriskante-KI-Systeme einzurichtende Qualitätsmanagementsystem ein Risikomanagementsystem gemäß Artikel 9 KI-VO umfassen muss.

- Nach Artikel 9 KI-VO muss das Risikomanagementsystem eingerichtet, angewandt, dokumentiert und aufrechterhalten werden.

- Ist ein iterativer Prozess, der während dem gesamten Lebenszyklus geplant, durchgeführt, überprüft und aktualisiert werden muss.

- Umfasst die Ermittlung, Analyse, Abschätzung, Bewertung und Bewältigung von Risiken.

- Zur Ermittlung geeigneter Risikomanagementmaßnahmen müssen hochrisiko-KI-Systeme getestet werden.

Worum handelt es sich beim NIST Risk Management Framework?

- Das NIST RMF ist ein strukturierter Ansatz, der Organisationen dabei unterstützen soll, Informationssicherheitsrisiken zu bewerten, zu managen und kontinuierlich zu überwachen.

- Bietet einen Prozess, der die Aktivitäten des Risikomanagements in den Bereichen Sicherheit, Datenschutz und Cyber Supply Chain in den Lebenszyklus der Systementwicklung integriert.

- RMF-Ansatz ist anwendbar auf jede Art von Systemen oder Technologien innerhalb von jeder Organisation.

- Das NIST RMF eignet sich zur Anwendung im Rahmen der Etablierung eines Risikomanagementsystems.

Welche Schritte definiert das NIST RMF?

- Vorbereitung der Organisation auf den Umgang mit Sicherheits- und Datenschutzrisiken.

- Kategorisierung des Systems und der verarbeiteten, gespeicherten und übermittelten Informationen auf Grundlage einer Auswirkungsanalyse.

- Auswahl der NIST SP 800-53-Kontrollen zum Schutz des Systems auf Grundlage der Risikobewertung(en).

- Implementierung der Kontrollen und Dokumentation des Einsatzes.

- Beurteilung der implementierten Kontrollen, ob sie wie geplant operieren und die gewünschten Ausgaben liefern.

- Autorisierung des Systems durch einen leitenden Beamten auf risikobasierter Entscheidungsgrundlage.

- Laufende Beobachtung der implementierten Kontrollen und Systemrisiken.

Durchführung einer Konformitätsbewertung

Was ist eine Konformitätsbewertung?

- Für den EU AI Act hat sich der EU-Gesetzgeber für das Regelungskonzept des Produktsicherheitsrechts entschieden.

- Bevor ein Produkt in der EU in Verkehr gebracht werden kann, muss der Hersteller eine Risikoanalyse durchführen und sicherstellen, dass bestimmte Vorschriften eingehalten werden.

- Diese Konformitätsbewertung reicht von der Entwurfs- bis zur Produktionsphase

- Die Ergebnisse müssen in die technische Dokumentation aufgenommen werden.

- Zum Nachweis der Einhaltung der EU-Vorschriften können harmonisierte Normen angewendet werden, welche sich bezüglich des EU AI Acts derzeit in der Ausarbeitung befinden.

- Zum Nachweis der Erfüllung der Anforderungen ist eine CE-Kennzeichnung erforderlich.

Was regelt der EU AI Act bezüglich der Konformitätsbewertung?

- Das Konformitätsbewertungsverfahren muss nach Art. 16 KI-VO für jedes Hochrisiko-KI-System zwingend durchgeführt werden und wird in Art. 43 KI-VO geregelt.

- Dadurch soll sichergestellt werden, dass das KI-System neben den jeweiligen EU-Harmonisierungsrechtsvorschriften auch den Anforderungen des EU AI Acts entspricht

- Ziel: Durch Sicherheit, Transparenz und Zuverlässigkeit Vertrauen in das KI-System schaffen.

- Anbieter müssen zum Nachweis der Erfüllung der Anforderungen an Hochrisikosysteme neben der Durchführung eines Konformitätsbewertungsverfahrens auch eine EU-Konformitätserklärung ausstellen und eine CE-Kennzeichnung anbringen.

- Das Konformitätsbewertungsverfahren kann auch davon abhängen, ob harmonisierte Normen (Art. 40 KI-VO) oder gemeinsame Spezifikationen (Art. 41 KI-VO) angewendet werden

- Unsere Empfehlung: Rechtzeitig eng mit den benannten Konformitätsbewertungsstellen zusammenarbeiten und frühzeitig interne Compliance-Strukturen aufbauen.

CE-Siegel nach erfolgter Konformität

Was ist ein CE-Siegel und wozu brauche ich ihn?

- Das CE-Zeichen ist ein Hinweis darauf, dass ein Produkt vom Hersteller geprüft wurde und dass es alle EU-weiten Anforderungen an Sicherheit, Gesundheitsschutz und Umweltschutz erfüllt.

- Pflicht für alle weltweit hergestellten Produkte, die in der EU vermarktet werden.

- Kennzeichnungspflicht besteht, sobald ein Produkt entsprechenden EU-Vorschriften unterliegt, die eine CE-Kennzeichnung vorschreiben.

- Gelten für ein Produkt mehrere EU-Vorschriften gleichzeitig, muss vor dem Anbringen des CE-Kennzeichens sichergestellt werden, dass alle einschlägigen Anforderungen erfüllt sind.

- Produkte dürfen nicht gekennzeichnet werden, wenn diese nicht vorgeschrieben ist oder wenn keine Vorschriften gelten.

Wie erhalte ich ein CE-Kennzeichen?

- Der Prozess läuft üblicherweise wie folgt ab:

- Risikokategorisierung des KI-Systems;

- Durchführung und Dokumentation einer Konformitätsbewertung;

- Unterzeichnen einer Konformitätserklärung;

- Anbringen des CE-Kennzeichens.

Was schreibt der EU AI Act hierzu vor?

- Artikel 48 KI-VO regelt die CE-Kennzeichnung an Hochrisiko-KI-Systemen.

- Grundsätzlich muss die CE-Kennzeichnung gut sichtbar, leserlich und dauerhaft an Hochrisiko-KI-Systemen angebracht werden.

- Ist dies nicht möglich wird sie auf der Verpackung oder beigefügten Dokumentation angebracht.

- Unterliegt das KI-System auch anderen Rechtsvorschriften, bedeutet das Anbringen des Kennzeichens, dass auch deren Anforderungen erfüllt sind.

- Die CE-Kennzeichnung signalisiert, dass das Hochrisiko-KI-System alle erforderlichen Anforderungen aus den Produktrechtsvorschriften erfüllt und schafft somit Vertrauen.

Komformitätsvermutung durch die Einhaltung von harmonisierten Normen

Was sind harmonisierte Normen der EU?

- Normen und andere Veröffentlichungen zur Standardisierung sind nicht verbindliche Leitlinien mit technischen Spezifikationen für Produkte, Dienstleistungen und Verfahren.

- Sie werden von privaten Normungsgremien in der Regel auf Initiative von Interessenträgern entwickelt, die einen entsprechenden Bedarf ermittelt haben.

- Europäische Normen werden von einem der drei europäischen Normungsgremien verabschiedet: CEN, CENELEC, ETSI.

- Harmonisierte Normen als besondere Kategorie europäischer Normen werden im Auftrag der EU-Kommission von den europäischen Normungsgremien erarbeitet.

- Während die Einhaltung freiwillig ist, wird mit dieser unter Beweis gestellt, dass ein Produkt/eine Dienstleistung im Einklang mit den technischen Anforderungen der EU-Rechtsvorschriften steht und damit ein bestimmtes Maß an Qualität, Sicherheit und Zuverlässigkeit erfüllt.

Was sagt der EU AI Act zu der Anwendung von harmonisierten Standards?

- Harmonisierte Normen und Normungsdokumente werden in Artikel 40 KI-VO geregelt.

- Stimmen Hochrisiko-KI-Systeme oder GPAI-Modelle mit harmonisierten Normen oder Teilen davon überein, wird eine Konformität mit den entsprechenden Anforderungen für diese Systeme und Modelle vermutet.

- CEN und CENELEC sind für die Entwicklung solcher KI-spezifischen Standards verantwortlich.

Wesentliche Änderungen und damit verbundene Pflichten

Wie definiert der EU AI Act eine "wesentliche Änderung" nach Artikel 3 Nr.23 KI-VO?

- Veränderung eines KI-Systems nach Inverkehrbringen oder Inbetriebnahme.

- Veränderung war in der ursprünglichen Konformitätsbewertung nicht geplant oder vorgesehen.

- Es kommt zu einer Änderung der Zweckbestimmung.

- Oder die Konformität des KI-Systems mit den Anforderungen an Hochrisiko-KI-Systeme wird beeinträchtigt.

- Nach Art. 43 (4) KI-VO gelten in der ursprünglichen Konformitätsbewertung vorab festgelegte Änderungen am System und seiner Leistung nicht als wesentliche Änderungen.

Welche Pflichten regelt der EU AI Act beim Eintreffen einer wesentlichen Änderung?

- Nach Artikel 43 (4) KI-VO müssen Hochrisiko-KI-Systeme im Falle einer wesentlichen Änderung einem neuen Konformitätsbewertungsverfahren unterzogen werden.

- Dies hängt nicht davon ab, ob das geänderte System weiterhin in Verkehr gebracht oder weitergenutzt werden soll.

- Der EU AI Act listet hierfür beispielhaft die Änderung des Betriebssystems oder der Softwarearchitektur auf.

- Änderungen, die den Algorithmus oder die Leistung des dazulernenden Systems betreffen, stellen keine wesentlichen Änderungen dar, falls sie vorab festgelegt und bewertet wurden.

General Purpose AI-Modelle (GPAI)

Was ist ein GPAI?

- General Purpose AI Modelle sind KI-Modelle mit allgemeinem Verwendungszweck, die nicht auf bestimmte Aufgaben abgestimmt sind und dazu in der Lage sind unterschiedliche Aufgaben kompetent zu erfüllen.

- Können in eine Vielzahl von nachgelagerten Systemen oder Anwendungen integriert werden.

- Typisches Beispiel ist ein großes Sprachmodell wie GPT-3, das Texte generieren und Fragen beantworten kann.

- Sie werden mit großen Datenmengen trainiert und nutzen Techniken wie selbstüberwachtes Lernen, um ihre Vielseitigkeit zu erreichen.

- Aufgrund ihrer breiten Anwendbarkeit und potenziellen Auswirkungen auf verschiedene Bereiche der Gesellschaft werden GPAI-Modelle im Rahmen des EU AI Acts besonders berücksichtigt und unterliegen spezifischen Regulierungen.

Was regelt der EU AI Act in Bezug auf GPAI-Modelle?

- Generell unterscheidet der EU AI Act zwischen „normalen" GPAI-Modellen und solchen mit systemischen Risiken.

- Die Vorschriften für GPAI-Modelle gelten ab dem 02. August 2025 mit speziellen Regeln für solche, die vor diesem Datum auf den Markt gebracht werden

- Nach Art. 53 KI-VO müssen technische Informationen über das Modell dokumentiert und zur Verfügung gestellt werden.

- Es müssen Strategien zur Einhaltung von Schutzrechten (z.B. Urheberrecht) entwickelt werden.

- Der für die Schulung des Modells verwendeten Inhalte müssen zusammengefasst und öffentlich zugänglich gemacht werden.

- Nach Art. 55 KI-VO müssen Anbieter die systemischen Risiken von GPAI-Modellen mit systemischen Risiken bewerten und mindern und weitere besondere Vorschriften einhalten.

Aufbau von KI-Kompetenzen

Was ist nach dem EU AI Act unter KI-Kompetenzen zu verstehen?

- Ausstattung von betroffenen Personen mit den notwendigen Konzepten, um fundierte Entscheidungen über KI-Systeme zu treffen.

- Diese Konzepte können folgendes beinhalten:

- korrekte Anwendung technischer Elemente;

- Maßnahmen bei der Verwendung;

- geeignete Auslegung der Ausgaben;

- Verständnis über die Auswirkungen der mithilfe von KI getroffenen Entscheidungen.

- Alle Akteure der KI-Wertschöpfungskette sollen mit Kenntnissen ausgestattet werden, mit denen sie in die Lage versetzt werden, die Verordnung angemessen einzuhalten und ordnungsgemäß durchzusetzen.

Was schreibt der EU AI Act in Bezug auf KI-Kompetenzen vor?

- Nach Artikel 4 KI-VO müssen Anbieter und Betreiber sicherstellen, dass ihr Personal und die von ihnen beauftragten Personen bei der Befassung mit KI-Systemen die notwendigen KI-Kompetenzen vorweisen.

Identifikation von KI-Systemen und Wichtigkeit der Bildung eines Registers

Wie werden KI-Systeme im EU AI Act definiert?

- KI-Systeme verfügen (im Gegensatz zu herkömmlicher Software) die Fähigkeit abzuleiten, welche die Erzeugung von Ausgaben wie Vorhersagen, Empfehlungen und Entscheidungen umfasst.

- Sie basieren auf maschinellem Lernen, logik- und wissensbasierten Ansätzen und können explizite oder implizite Ziele verfolgen, die sich von der ursprünglichen Zweckbestimmung unterscheiden können.

- Sie agieren (teil-)autonom, sind lernfähig und können während der Nutzung Veränderungen vornehmen und unabhängig von menschlichem Eingreifen agieren.

- KI-Systeme können eigenständig oder als Produktbestandteil genutzt werden, unabhängig davon, ob sie physisch integriert oder extern eingesetzt werden.

Warum sollte ein Systemregister für KI-Systeme gebildet werden?

- Nach der Identifikation von KI-Systemen sollten diese in einem Register gesammelt werden.

- Es ermöglicht eine zentrale Übersicht über alle eingesetzten KI-Systeme, einschließlich ihrer Funktionen, Einsatzbereiche und Verantwortlichen. Dies schafft Transparenz und erleichtert die Verwaltung.

- Ein Register hilft bei der Einhaltung gesetzlicher Vorgaben, z.B. durch Dokumentation der Risikokategorien und Einsatzumstände.

- Die Erfassung aller KI-Systeme ermöglicht die Identifikation und Bewertung potenzieller Risiken z.B. in Bezug auf Datenschutz, Diskriminierung oder Sicherheitsprobleme.

- Ein Register erleichtert die Nachverfolgung von Updates, Wartungsanforderungen und technologischen Veränderungen, und sichert dadurch einen reibungslosen Betrieb.

- Durch die Dokumentation können klare Zuständigkeiten und Verantwortlichkeiten zugewiesen werden.

- Ein zentrales Register dient als Wissensbasis und erleichtert den Austausch zwischen Abteilungen, die KI-Systeme entwickeln, nutzen oder überwachen.

Durchsetzende Behörden

Wer setzt den EU AI Act auf europäischer Ebene durch?

- Europäische Kommission ist verantwortlich für die allgemeine Koordination und Überwachung der Umsetzung.

- Innerhalb dieser erleichtert das KI-Büro die einheitliche Anwendung des Gesetzes in den Mitgliedstaaten.

- Der Europäische Ausschuss für KI besteht aus Vertretern der Mitgliedstaaten und dient als Plattform für den Austausch bewährter Verfahren und die Entwicklung gemeinsamer Leitlinien.

- Dieser unterstützt die Kommission bei der Umsetzung des EU AI Acts.

Wer setzt den EU AI Act auf nationaler Ebene in Deutschland durch?

- Grundsätzlich muss jeder EU-Mitgliedstaat hierfür nationale Behörden benennen.

- In Deutschland wurde die Bundesnetzagentur zur nationalen Marktüberwachungsbehörde für die KI-Aufsicht ernannt.

- Die nationalen Behörden sind neben der Marktüberwachung auch verantwortlich für die Einhaltung der Vorschriften des EU AI Acts.

- Arbeiten zusammen mit europäischen Institutionen.

Weitere Informationen zum EU AI Act

Quellen

- EU AI Act - Vollständiger Gesetzestext im Amtsblatt der Europäischen Union

- ISO/IEC 42001 - AI Management System Standard

- AI-Pact und dessen Bedeutung - Europäische Kommission

- Zeitplan und wichtige Fristen des EU AI Acts

- Grundlegende Analyse des EU AI Acts - Sicherheit und Risiken

- Leitfaden zur Konformitätsbewertung in der EU

- CE-Kennzeichnung - Anforderungen und Umsetzung

- NIST Risk Management Framework - Grundlagen und Anwendung

- Europäische Standards und Normung im Kontext des EU AI Acts

- Analyse der überarbeiteten Fassung des EU AI Acts

- FAQ zu General Purpose AI-Modellen im EU AI Act

- Detaillierte Analyse zu GPAI im Kontext des EU AI Acts

- Nationale Marktüberwachungsbehörden und KI-Aufsicht